مدتها است که تحقیقات گستردهای در زمینه سرعت بالای فناوری تشخیص چهره با استفاده از #هوش_مصنوعی ادامه دارد. این تحقیقات بر اساس دادههای حاصل از دوربینهای امنیتی و ویژگی Facetime iOS شرکت اپل در حال پیگیری است.

اما درمورد نرمافزار تشخیص چهره پرسشهای اخلاقی زیادی مطرح شده و محققان هوش مصنوعی به برنامههای خود از لحاظ اخلاقی با تردید نگاه میکنند.

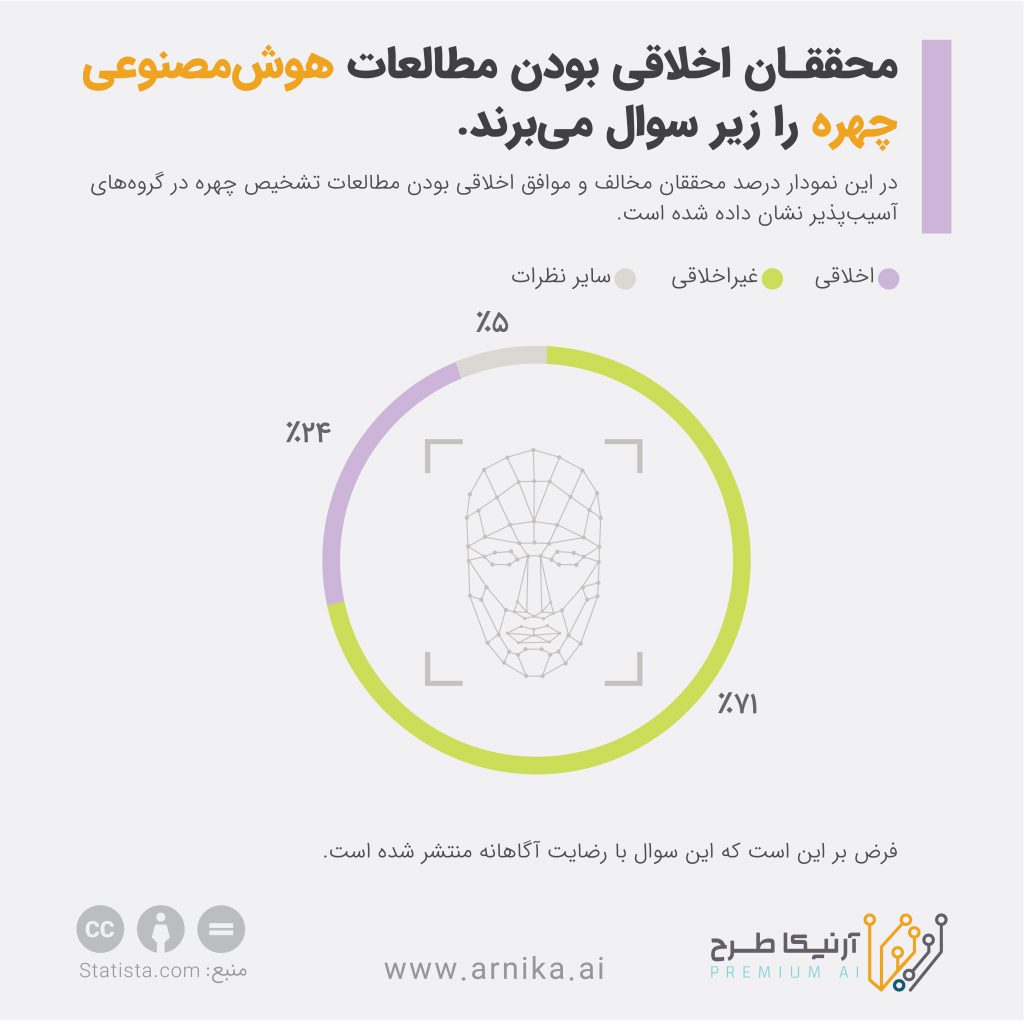

نتیجه منتشر شده از یک نظرسنجی در نیچر نشان میدهد که بیشتر محققان، استفاده از فناوری #تشخیص_چهره در گروهها و جمعیتهای آسیبپذیر را حتی با رضایت آگاهانه افراد، غیراخلاقی میدانند. 780 محقق در این نظرسنجی شرکت کردهاند که 71 درصد آنها تشخیص چهره گروههای آسیبپذیر را غیراخلاقی پنداشتهاند. از طرفی 24 درصد دیگر از محققان این امر را اخلاقی دانستهاند و تاکید کردهاند که تنها برخی از استفادههای کنونی آن غیراخلاقی است.

بررسی آنالیز چهره انسان اطلاعاتی درباره ویژگیهای صورت و بدن در اختیار سایرین قرار میدهد همچنین با استفاده از آن میتوان جنبههای هویتی وی را پیشبینی کرد. استفاده از یک وسیله بهعنوان مصرفکننده مانند گوشی آیفون، دسترسی به لایه امنیتی بیشتری را نسبت به برنامههای کاربردی برای ردیابی و اجرای قانون امکانپذیر میکند.

از طرفی با استفاده از تجزیهوتحلیل عکسهای موجود در رسانههای اجتماعی، پیشرفت زیادی در زمینه #فناوری_تشخیص_چهره به وجود آمده است.

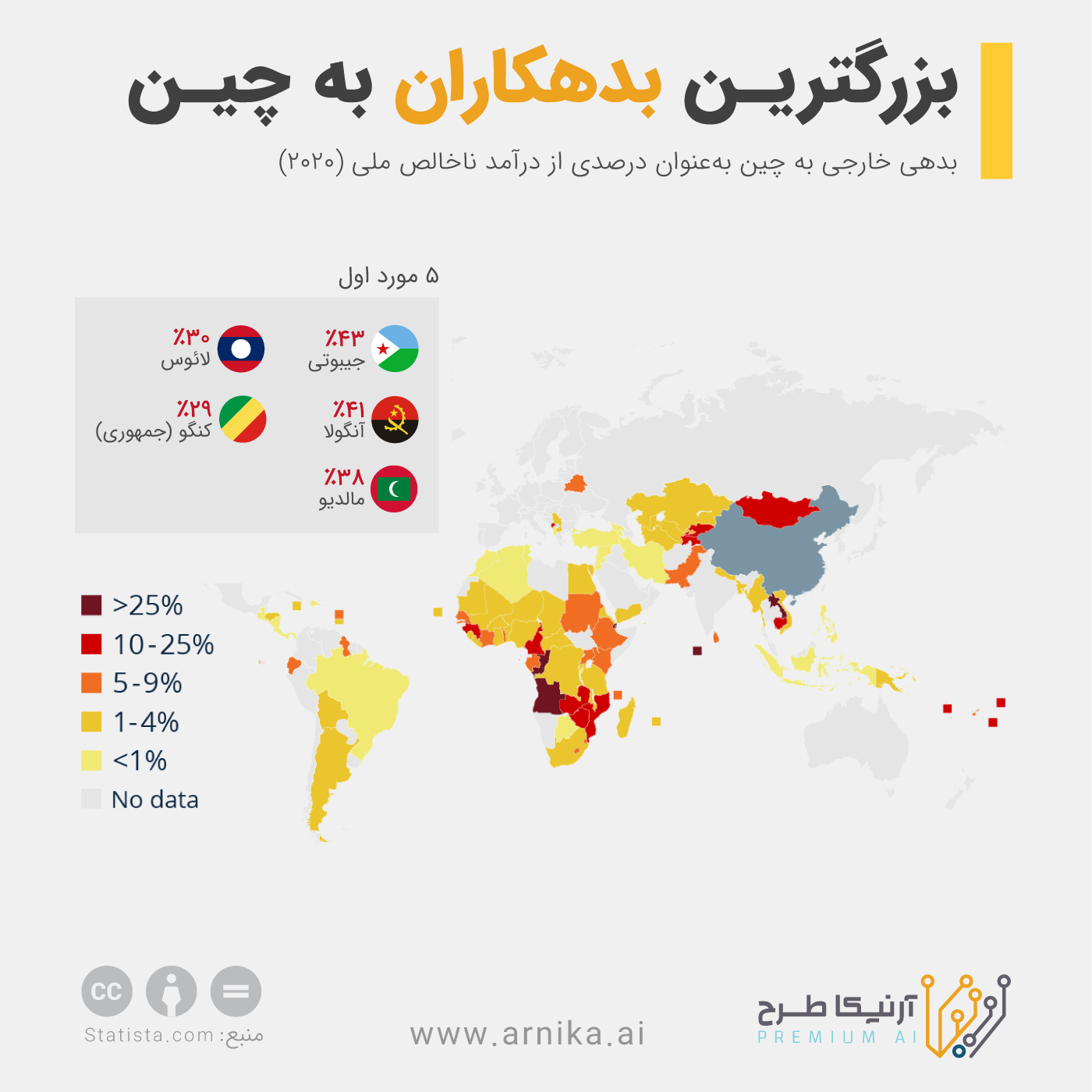

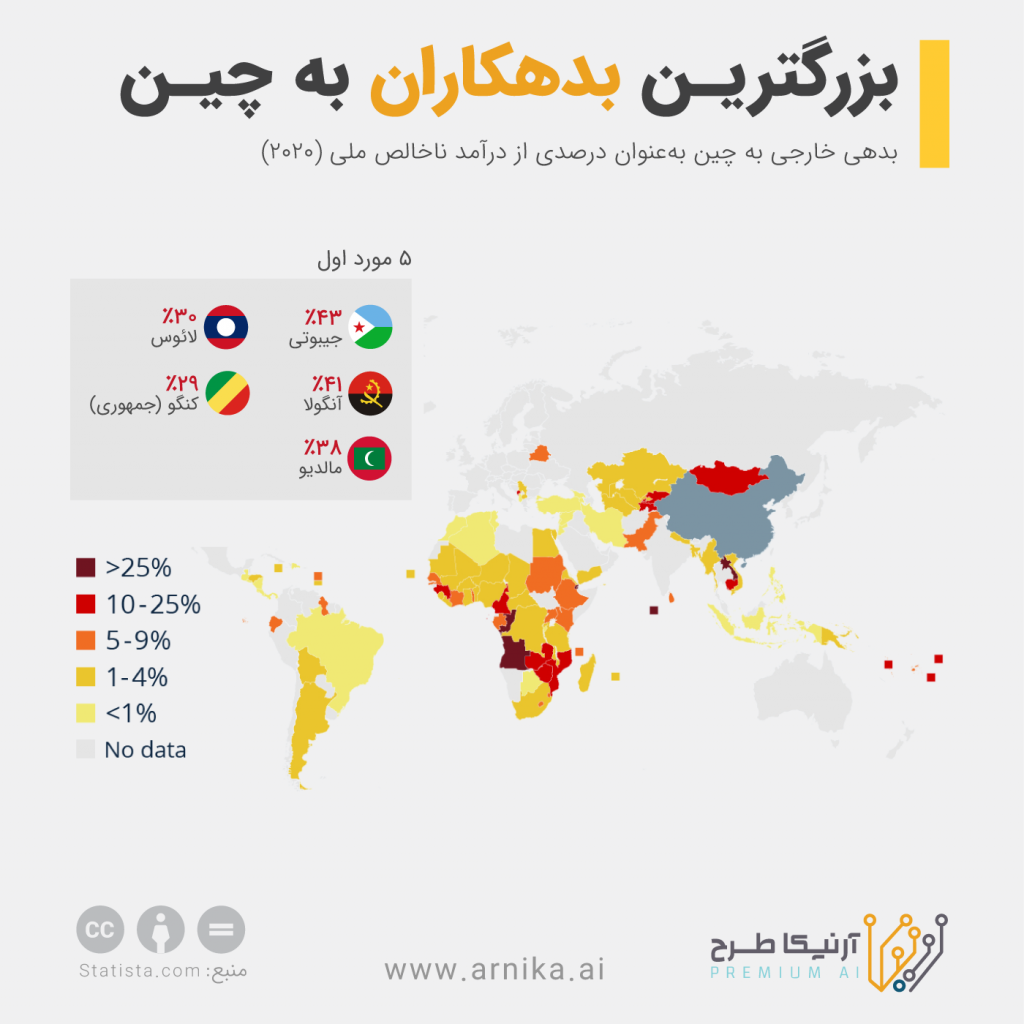

در نظرسنجی انجامگرفته، جمعیت مسلمان اویغور در سین کیانگ چین بهعنوان یکی از نمونهها برای مطالعات غیراخلاقی تشخیص چهره معرفی شدهاند. گفته شده که تعداد زیادی از این افراد درون اردوگاهها زندانی هستند. این افراد بهصورت آگاهانه و با رضایت در تحقیقات صورتگرفته شرکت کردهاند یا اختیاری وجود نداشته است؟

این پرسش برای محققان تردید بزرگی درباره غیراخلاقی بودن استفاده از تشخیص چهره در این گروه به وجود آورده است. اخیرا نگرانیهای زیادی درباره ردیابی گروههای آسیبپذیر مانند اویغورها در چین توسط سیستم تشخیص چهره ایجاد شده است.